-

Frank Glencairn

- Beiträge: 25017

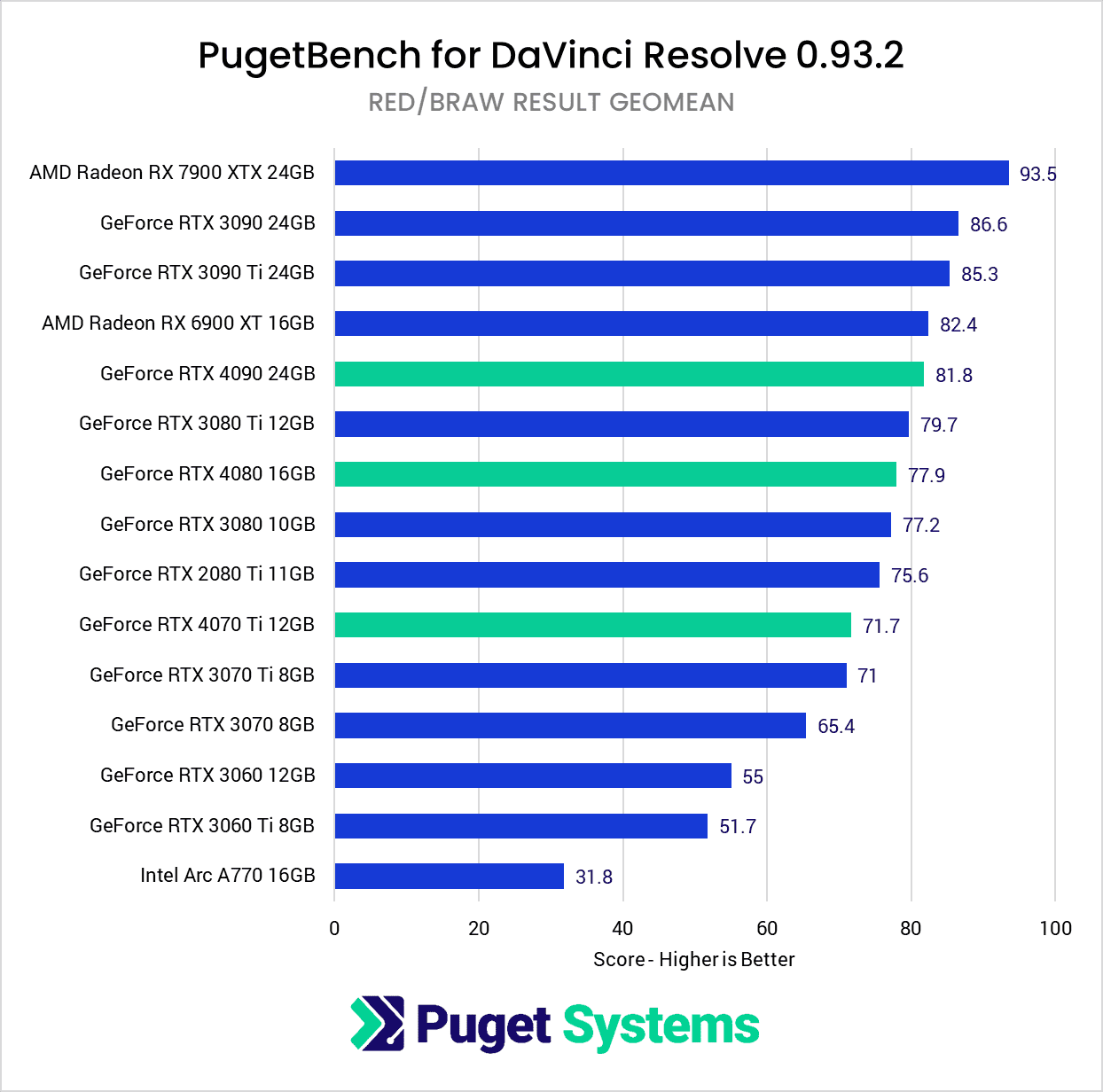

Ich versteh sowieso nicht warum jemand ne teure und langsamere A770 ner billigeren und schnelleren 3600 vorziehen sollte.

Sapere aude - de omnibus dubitandum

Du hast keine ausreichende Berechtigung, um die Dateianhänge dieses Beitrags anzusehen.

Das kannst du mal iasi fragen ;) Irgendwas mit Geld in den Rachen werfen und so :D

-

Frank Glencairn

- Beiträge: 25017

Markenhass als Kaufentscheidungsfindung hab ich jetzt mal außen vor gelassen.

Sapere aude - de omnibus dubitandum

Zur 770 vmtl nicht, zu dem Ami-Preisen ist die 750 die schnellere Karte auf den Euro (oder dort halt Dollar). Ich weiß nicht ob da Preis/Leistung eine Rolle spielt, aber eigentlich ist es immer noch die treffsicherste Metrik für Grafikkartenvergleiche.Frank Glencairn hat geschrieben: ↑Do 06 Apr, 2023 11:56 Ich versteh sowieso nicht warum jemand ne teure und langsamere A770 ner billigeren und schnelleren 3600 vorziehen sollte.

image_2023-04-06_115643098.png

Diese Vergleichskalkulationen im einstelligen Prozentbereich gepaart mit gebetsmühlenartiger Schönrederei von Intels Erstlingswerk sind schon ein Stück weit belustigend.

-

dienstag_01

- Beiträge: 13877

Ist das denn wirklich so schlimm, dass jemand eine Grafikkarte von Intel kauft und damit zufrieden ist.

Puh.

Puh.

Nein, schlimm ist die Missionierung auf Basis falscher Fakten.dienstag_01 hat geschrieben: ↑Do 06 Apr, 2023 14:36 Ist das denn wirklich so schlimm, dass jemand eine Grafikkarte von Intel kauft und damit zufrieden ist.

Puh.

-

dienstag_01

- Beiträge: 13877

Ah, ja, nagut, Missionierung ist in diesem Forum wirklich ein nogo ;)MK hat geschrieben: ↑Do 06 Apr, 2023 14:40Nein, schlimm ist die Missionierung auf Basis falscher Fakten.dienstag_01 hat geschrieben: ↑Do 06 Apr, 2023 14:36 Ist das denn wirklich so schlimm, dass jemand eine Grafikkarte von Intel kauft und damit zufrieden ist.

Puh.

Die da wären?MK hat geschrieben: ↑Do 06 Apr, 2023 14:40Nein, schlimm ist die Missionierung auf Basis falscher Fakten.dienstag_01 hat geschrieben: ↑Do 06 Apr, 2023 14:36 Ist das denn wirklich so schlimm, dass jemand eine Grafikkarte von Intel kauft und damit zufrieden ist.

Puh.

Für neueste Linux Treiber, guck mal auf der Intel Arc Seite nach.cantsin hat geschrieben: ↑Sa 04 Mär, 2023 15:03 Sehe ich das richtig, dass sich die Diskussion hier mittlerweile zu Nvidia vs. AMD verschoben hat?

Gibt's denn schon irgendwelche Praxiserfahrungen mit den Intel Arcs in Resolve?

Aus meiner Linuxer-Sicht ist bei denen attraktiv, dass da der Treibersupport seit den letzten Linux-Kernel-Versionen out-of-the-box und offiziell von Intel entwickelt im Betriebssystem sitzt und man sich nicht mehr mit Nvidias proprietären (und u.a. wegen eingeschränkter Wayland-Kompatibilität problematischen) Treibern rumschlagen muss....

Gentlemen Start Your Engines

Du hast keine ausreichende Berechtigung, um die Dateianhänge dieses Beitrags anzusehen.

Preis-Leistung ist für Leute wie markusG egal.

Geld hat man als Profi eh im Überfluss.

Wer hingegen auch auf die Leistung achtet, die man pro Euro bekommt, schaut sich so etwas an und dann was gerade für Grafikkarten angesagt ist:

Eine RX 6950 XT bekommt man aktuell z.B. für 650€. ;)

Man bekommt also 2 dieser AMD-Karten für den Preis einer RTX 4080.

Dankedienstag_01 hat geschrieben: ↑Do 06 Apr, 2023 14:36 Ist das denn wirklich so schlimm, dass jemand eine Grafikkarte von Intel kauft und damit zufrieden ist.

Puh.

Nein ist nicht schlimm, Ich baue gute Hardware für meine Einsätze selbst zusammen.

Für meine Arbeiten mit XAVC HS 4K 422 10 bit, (ist ein HEVC Material) reicht meine ARC 770 16GB allemal.

Hier nochmal Tests was die Karte nicht kann! ;-)

Sind auch Puget System Test.

Gentlemen Start Your Engines

Du hast keine ausreichende Berechtigung, um die Dateianhänge dieses Beitrags anzusehen.

Du hast die 147% von Hyper Encoding übersehen.DKPost hat geschrieben: ↑Mi 05 Apr, 2023 06:05Also 3% schneller als eine RTX3060 ist jetzt nicht gerade beeindruckend.DaCarlo hat geschrieben: ↑Mi 05 Apr, 2023 01:30

Es gibt neue updates und Empfehlungen wie man seinen Intel Rechner, (siehe oben Ausstattung)

bestmöglich einstellen und updaten bzw. beachten soll.

Mein Rechner läuft prima mit Resolve und Edius X, wobei die K Prozessoren mit Quick Sync, auf 2 x 27 Zoll

Bildschirmen, eine gute Zusatz Leistung erbringen.

Das passiert bei Hyper Encoding!

Dazu benötigst du aber Intel K Prozessoren mit Integrierter Grafik.

Gentlemen Start Your Engines

Du hast keine ausreichende Berechtigung, um die Dateianhänge dieses Beitrags anzusehen.

Übersehen hat hier keiner was, Screenshots machen will halt gelernt sein:

Du hast keine ausreichende Berechtigung, um die Dateianhänge dieses Beitrags anzusehen.

Leider ist die bei GPU Compute über 50% langsamer als die 4080 und wenn man darauf hauptsächlich angewiesen ist bringt das nichts... und bei den aktuellen Strompreisen zwei Karten in den Rechner stecken? Da hat man abgesehen von der Zeitersparnis die Mehrkosten für die 4080 schnell wieder raus...

Und die 4070 Ti gibt es ja auch noch, immerhin auch fast 30% schneller bei GPU Compute als die 6950 XT, dafür 14% langsamer bei DirectX 11... da skaliert der Preis aber auch deutlich linearer mit der Leistung als bei der 4080.

Ich würde mir aber momentan falls nicht gerade was kaputt geht auch keine neue Karte kaufen da die Preise zu dynamisch sind, gleiches gilt für SSDs bei denen mittlerweile im 2 TB Bereich der freie Fall eingeleitet ist und die 4 TB Modelle hoffentlich bald folgen.

Nö, es gibt halt Leute die kein Cherry Picking betreiben und Preis/Leistung eher ganzheitlich betrachten. Das mit der Markenkritik kann trotzdem von dir ;)

Nochmal blender: Als Profi bezahlt man für mehr Leistung eben auch mal etwas mehr - denn am Ende macht man damit mehr Geld. Wobei die A770 auch nicht unbedingt ein Schnäppchen ist, im Vergleich zur Rtx3060 o. 3060ti...

Nach wenigen Gigs hat sich die Neuanschaffung hoffentlich amotisiert, sonst macht man was falsch.

Du hast keine ausreichende Berechtigung, um die Dateianhänge dieses Beitrags anzusehen.

Zuletzt geändert von markusG am Fr 07 Apr, 2023 08:57, insgesamt 5-mal geändert.

Die Realsatire hier im Forum hat ein neues Level erreicht...

Stimmt doch gar nicht, was du da erzählst.MK hat geschrieben: ↑Fr 07 Apr, 2023 05:58Leider ist die bei GPU Compute über 50% langsamer als die 4080 und wenn man darauf hauptsächlich angewiesen ist bringt das nichts... und bei den aktuellen Strompreisen zwei Karten in den Rechner stecken? Da hat man abgesehen von der Zeitersparnis die Mehrkosten für die 4080 schnell wieder raus...

Und die 4070 Ti gibt es ja auch noch, immerhin auch fast 30% schneller bei GPU Compute als die 6950 XT, dafür 14% langsamer bei DirectX 11... da skaliert der Preis aber auch deutlich linearer mit der Leistung als bei der 4080.

Ich würde mir aber momentan falls nicht gerade was kaputt geht auch keine neue Karte kaufen da die Preise zu dynamisch sind, gleiches gilt für SSDs bei denen mittlerweile im 2 TB Bereich der freie Fall eingeleitet ist und die 4 TB Modelle hoffentlich bald folgen.

Schau dir die verlinkten Ergebnisse für Raw in Resolve an.

Selbst die RTX 4090 ist hier schon langsamer als die 6900 XT.

Bei AMD gehen die Preise runter.

Nvidia denkt hingegen, mit der Mär von 50% könne man die Preise hoch halten.

Das geht nun also so weit, dass man für weniger Geld zwei 6950XT in den Rechner statt einer 4090 stecken könnte.

Für den Preis einer 4080 bekommt man die Power von zwei 6950XT. Dann ist auch die GPU-Power auf AMD-Seite höher.

Du meinst das Märchen erzählen über Mittelklassekarten, die die High End-Konkurrenz weit hinter sich lassen. :)

Im Gespann mit einer Intel K-CPU ist die Arc Pro in manchen Bereichen auch in Augenhöhe mit den viel teureren Nvidias.

Was GPU Compute ist weißt Du anscheinend nicht, schade.

Vorschlag: Ich kaufe eine 6950 XT und wenn die bei GPU Compute langsamer ist krieg ich von Dir die 649 EUR :-)

Nein, Leute die Screenshots posten wo wesentliche Elemente abgeschnitten sind, und dann behaupten dass man den Teil der fehlt wohl übersehen hätte. LOL

-

Frank Glencairn

- Beiträge: 25017

Das ist nur ne Metrik, aber in der Realität irrelevant, weil selbst ne uralte GTX980 raw schon schnell genug für alles abspielen konnte.

Dummerweise skaliert das halt nicht so einfach bei Video Anwendungen.

Sapere aude - de omnibus dubitandum

Was meinst du wohl, wie eine RTX 4090 in einem Rechner mit einer alten i3-CPU abschneiden würde?

Die Arc Pro entfaltet im Zusammenspiel mit einem Intel-K-Prozessor nochmal mehr Leistung.

Man muss also durchaus Systeme differenziert betrachten.

Bei in Resolve schneiden die 4000er mit Raw auf der Timeline z.B. nicht gut ab.

Intel Arc bietet hingegen hardwarebeschleunigte Kodierung für AV1.

Hier zu behaupten die teuren 4000er seien generell immer die Schnellsten, stimmt nun einmal nicht.

Was sie aber sind: Hochpreisig.

Die heute üblichen/verfügbaren Benchmarks sind halt auch nicht so praxisnah, zumindest nicht für Videoanwendungen.

h264/h265 GPU-Encoding-Benchmarks sind zwar nice to have, aber eigentlich müsste da auch die Bildqualität des Outputs gemessen werden. I.d.R. sind diese GPU-basierten Encodings ja nur für schnellen Turnaround zu gebrauchen und erreichen nur die Bildqualität, die ein langsameres CPU-basiertes Encoding (z.B. mit ffmpeg/Handbrake) auch mit 50% der Dateigröße hinkriegt.

Und Formate wie Braw fordern fast nichts von der GPU.

Aussagekräftig wäre:

- Abspielperformance/FPS von technisch wirklich anspruchsvollem Videomaterial wie 6K/8K Open Gate 10bit 4:2:2 h265 in den Timelines von Resolve, Premiere & Co.

- Abspielperformance/FPS von anspruchsvollen Plugins wie Neat Video Pro und/oder Dehancer (mit Settings, die die GPU fordern).

- Zunehmend auch: Renderperformance von KI-Bildgeneratoren wie Stable Diffusion, wo dann tatsächlich GPU Compute die entscheidende Rolle spielt, bzw. 50% weniger GPU Compute-Performance auch ungefähr doppelt so lange Renderzeiten zur Folge hat...

h264/h265 GPU-Encoding-Benchmarks sind zwar nice to have, aber eigentlich müsste da auch die Bildqualität des Outputs gemessen werden. I.d.R. sind diese GPU-basierten Encodings ja nur für schnellen Turnaround zu gebrauchen und erreichen nur die Bildqualität, die ein langsameres CPU-basiertes Encoding (z.B. mit ffmpeg/Handbrake) auch mit 50% der Dateigröße hinkriegt.

Und Formate wie Braw fordern fast nichts von der GPU.

Aussagekräftig wäre:

- Abspielperformance/FPS von technisch wirklich anspruchsvollem Videomaterial wie 6K/8K Open Gate 10bit 4:2:2 h265 in den Timelines von Resolve, Premiere & Co.

- Abspielperformance/FPS von anspruchsvollen Plugins wie Neat Video Pro und/oder Dehancer (mit Settings, die die GPU fordern).

- Zunehmend auch: Renderperformance von KI-Bildgeneratoren wie Stable Diffusion, wo dann tatsächlich GPU Compute die entscheidende Rolle spielt, bzw. 50% weniger GPU Compute-Performance auch ungefähr doppelt so lange Renderzeiten zur Folge hat...

Resolve skaliert nicht schlecht.Frank Glencairn hat geschrieben: ↑Fr 07 Apr, 2023 14:30Das ist nur ne Metrik, aber in der Realität irrelevant, weil selbst ne uralte GTX980 raw schon schnell genug für alles abspielen konnte.

Dummerweise skaliert das halt nicht so einfach bei Video Anwendungen.

Schon das Zusammenspiel von Intel k-CPU und Intel Arc Pro bringt merklich etwas.

Mit zwei Karten kommt man auf mehr als 150% der Leistung einer Karte.

Was du hier jetzt nicht anfangen musst, ist Testergebnisse, die dir nicht ins Konzept passen, als irrelevant darzustellen.

Eine GTX980 kommt sehr wohl schnell ans Limit, wenn Raw auf der Timeline ist.

Was nicht auffällt, ist bei H264 ein Unterschied zwischen 100fps und 120fps.

48fps bei Raw bedeutet bei 50p hingegen schon rucklige Darstellung.

Was hat das mit dem abgeschnittenen Screenshot-Fail weiter oben zu tun? Richtig, nichts :-)iasi hat geschrieben: ↑Fr 07 Apr, 2023 14:37 Was meinst du wohl, wie eine RTX 4090 in einem Rechner mit einer alten i3-CPU abschneiden würde?

Die Arc Pro entfaltet im Zusammenspiel mit einem Intel-K-Prozessor nochmal mehr Leistung.

Man muss also durchaus Systeme differenziert betrachten.

Bei in Resolve schneiden die 4000er mit Raw auf der Timeline z.B. nicht gut ab.

Intel Arc bietet hingegen hardwarebeschleunigte Kodierung für AV1.

Hier zu behaupten die teuren 4000er seien generell immer die Schnellsten, stimmt nun einmal nicht.

Was sie aber sind: Hochpreisig.

-

Frank Glencairn

- Beiträge: 25017

Nö, eine 980 spielt raw im Schlaf ab. Und ja, wir reden hier von deniasi hat geschrieben: ↑Fr 07 Apr, 2023 14:48

Was du hier jetzt nicht anfangen musst, ist Testergebnisse, die dir nicht ins Konzept passen, als irrelevant darzustellen.

Eine GTX980 kommt sehr wohl schnell ans Limit, wenn Raw auf der Timeline ist.

Was nicht auffällt, ist bei H264 ein Unterschied zwischen 100fps und 120fps.

48fps bei Raw bedeutet bei 50p hingegen schon rucklige Darstellung.

realworld relevanten FPS wie 24/25, nicht von irgendwelchen Phantasiewerten.

Kein Mensch hat ne 120 fps Timeline.

Und selbst bei Youtube Kindergarten Timelines mit 50fps merkst du keinen Unterschied zwischen einer Intel und ner RTX 4090.

Was hast du dann davon, daß die Intel theoretisch noch ein bisschen mehr könnte - alles völlig irrelevante Werte.

Sapere aude - de omnibus dubitandum

Du hast auch bei RedRaw einen Unterschied beim Export zwischen CPU und GPU.cantsin hat geschrieben: ↑Fr 07 Apr, 2023 14:39 Die heute üblichen/verfügbaren Benchmarks sind halt auch nicht so praxisnah, zumindest nicht für Videoanwendungen.

h264/h265 GPU-Encoding-Benchmarks sind zwar nice to have, aber eigentlich müsste da auch die Bildqualität des Outputs gemessen werden. I.d.R. sind diese GPU-basierten Encodings ja nur für schnellen Turnaround zu gebrauchen und erreichen nur die Bildqualität, die ein langsameres CPU-basiertes Encoding (z.B. mit ffmpeg/Handbrake) auch mit 50% der Dateigröße hinkriegt.

Und Formate wie Braw fordern fast nichts von der GPU.

Aussagekräftig wäre:

- Abspielperformance/FPS von technisch wirklich anspruchsvollem Videomaterial wie 6K/8K Open Gate 10bit 4:2:2 h265 in den Timelines von Resolve, Premiere & Co.

- Abspielperformance/FPS von anspruchsvollen Plugins wie Neat Video Pro und/oder Dehancer (mit Settings, die die GPU fordern).

- Zunehmend auch: Renderperformance von KI-Bildgeneratoren wie Stable Diffusion, wo dann tatsächlich GPU Compute die entscheidende Rolle spielt, bzw. 50% weniger GPU Compute-Performance auch ungefähr doppelt so lange Renderzeiten zur Folge hat...

Äh - nö.Frank Glencairn hat geschrieben: ↑Fr 07 Apr, 2023 15:32Nö, eine 980 spielt raw im Schlaf ab. Und ja, wir reden hier von deniasi hat geschrieben: ↑Fr 07 Apr, 2023 14:48

Was du hier jetzt nicht anfangen musst, ist Testergebnisse, die dir nicht ins Konzept passen, als irrelevant darzustellen.

Eine GTX980 kommt sehr wohl schnell ans Limit, wenn Raw auf der Timeline ist.

Was nicht auffällt, ist bei H264 ein Unterschied zwischen 100fps und 120fps.

48fps bei Raw bedeutet bei 50p hingegen schon rucklige Darstellung.

realworld relevanten FPS wie 24/25, nicht von irgendwelchen Phantasiewerten.

Kein Mensch hat ne 120 fps Timeline.

Und selbst bei Youtube Kindergarten Timelines mit 50fps merkst du keinen Unterschied zwischen einer Intel und ner RTX 4090.

Was hast du dann davon, daß die Intel theoretisch noch ein bisschen mehr könnte - alles völlig irrelevante Werte.

Die Zeiten mit 2.8k/24p sind vorbei.

Hallo! Wir sind mittlerweile bei Kamera unter 5k$ die 8k/50p in Raw aufnehmen.

Deine 980 spielt da schon allein deshalb nicht mehr mit, weil es ihr an Speicher fehlt.

50fps-Timeline sollte heute hardwareseitig möglich sein.

-

Frank Glencairn

- Beiträge: 25017

25/24 fps sind nicht vorbei sondern der Industriestandard hier.

50 fps sind weder ein Broadcast, noch ein Kino Standard, 50 fps sind gar nix, und damit völlig irrelevant für professionelle Arbeit.

50 fps sind weder ein Broadcast, noch ein Kino Standard, 50 fps sind gar nix, und damit völlig irrelevant für professionelle Arbeit.

Sapere aude - de omnibus dubitandum

50fps sind Sendestandard.Frank Glencairn hat geschrieben: ↑Fr 07 Apr, 2023 16:26 25/24 fps sind nicht vorbei sondern der Industriestandard hier.

50 fps sind weder ein Broadcast, noch ein Kino Standard, 50 fps sind gar nix, und damit völlig irrelevant für professionelle Arbeit.

24fps waren ökonomischen Überlegungen geschuldet, die sich zu einem Quasistandard festgefressen haben.

Kein Gamer akzeptiert heute noch 24fps.

Im Internet sind die 24fps nicht relevant.

Auch die Kinoprojektoren beherrschen mittlerweile mehr als 24fps.

Avatar 2 war doch recht erfolgreich - oder nicht?

Man könnte auch mit 48fps und 360°Shutter aufnehmen und an der Bewegungsunschärfe würde sich nichts ändern - nur die Bewegungen wären flüssiger und nicht rucklig. Wer erhebt denn bitte eine technische und qualitative Schwäche zu einem Standard? :)

-

Frank Glencairn

- Beiträge: 25017

Ja, für 720 (IRT HDF03a 1.1 und IRT HDF03b 1.1) - das haben wir doch hoffentlich längst hinter uns gelassen, oder wie viel drehst du noch ion 720?

Ein weiteres Märchen, daß auch durch ständige Wiederholung nicht wahrer wird.

Spielkinder sind für die Video/Film Produktion völlig irrelevant.

Statt ständig solches Zeug aus dem Hut zu ziehen könntest du doch einfach folgendes in deine Signatur schreiben:

"ich glaube fest daran daß höhere Zahlen immer besser sind und außerdem Lawrence von Arabien".

Sapere aude - de omnibus dubitandum

-

Darth Schneider

- Beiträge: 21381

@iasi

Kino ist doch meistens immer noch 24FpS.

Netflix und Co. und heute, Content für TV…?

Keine Ahnung, aber ich denke auch eher 24/25/30 FpS als 50/60 FpS..

(Jetzt mal abgesehen vom Sport wegen der SloMos..)

Ich finde jedenfalls wenn die Bewegungen dann flüssiger sind sieht das immer mehr nach Video aus…

Mir gefällt darum 25 FpS immer noch besser als 50FpS..

Man schreibt auch nicht so viele Bilder/Daten weg..;)

Und wurde Avatar 2 nicht mit einer höheren Framerate gedreht vor allem aus technischen Gründen wegen dem 3D ?

Der einzige Grund warum ich nicht immer mit 24FpS filme ist höchstens noch weil ich mir nicht ganz sicher bin ob das alle TVs, Smartphone und Monitore auch richtig abspielen können.

Darum bleibe ich meistens bei 25FpS..

Games sind wieder ein ganz anderes Thema, das soll ja auch auf möglichst vielen Rechnern und Screens überall möglichst flüssig laufen.

Womöglich sind dabei höhere Frameraten ein Vorteil.

Gruss Boris

Kino ist doch meistens immer noch 24FpS.

Netflix und Co. und heute, Content für TV…?

Keine Ahnung, aber ich denke auch eher 24/25/30 FpS als 50/60 FpS..

(Jetzt mal abgesehen vom Sport wegen der SloMos..)

Ich finde jedenfalls wenn die Bewegungen dann flüssiger sind sieht das immer mehr nach Video aus…

Mir gefällt darum 25 FpS immer noch besser als 50FpS..

Man schreibt auch nicht so viele Bilder/Daten weg..;)

Und wurde Avatar 2 nicht mit einer höheren Framerate gedreht vor allem aus technischen Gründen wegen dem 3D ?

Der einzige Grund warum ich nicht immer mit 24FpS filme ist höchstens noch weil ich mir nicht ganz sicher bin ob das alle TVs, Smartphone und Monitore auch richtig abspielen können.

Darum bleibe ich meistens bei 25FpS..

Games sind wieder ein ganz anderes Thema, das soll ja auch auf möglichst vielen Rechnern und Screens überall möglichst flüssig laufen.

Womöglich sind dabei höhere Frameraten ein Vorteil.

Gruss Boris

Aktuelle Beiträge [alle Foren]

» ARRI ALEXA 35 Sensor-Bildqualität, Rolling Shutter, Dynamik - Die neue Referenz?

von Darth Schneider - Do 21:34

von Darth Schneider - Do 21:34

» Canon stellt Hybrid-Objektive RF 70-200mm F2.8, 50mm F1.4 und 24mm F1.4 vor

von BildTon - Do 21:31

von BildTon - Do 21:31

» Panasonic kündigt 4K-Camcorder HC-VX3 und Full-HD 2K-Camcorder HC-V900 an

von Skeptiker - Do 19:59

von Skeptiker - Do 19:59

» Neue Apple MacBook Pros mit M4 und bis zu 128 GB Arbeitsspeicher und 8 TB SSD

von Rick SSon - Do 18:08

von Rick SSon - Do 18:08

» Nikon kündigt Entwicklung von Powerzoom Nikkor 28-135mm f/4 PZ für Video an

von GaToR-BN - Do 12:49

von GaToR-BN - Do 12:49

» iMac mit M4-Chip: Jetzt minimal 16 GB RAM, schneller und zugleich günstiger

von Bildlauf - Mi 14:17

von Bildlauf - Mi 14:17

» Sony veröffentlicht neue Version des Remote-Toolkits samt Camera Remote Command

von slashCAM - Di 12:39

von slashCAM - Di 12:39

neuester Artikel

Vollformat Pro DSLM: Canon EOS R5 Mark II im Praxistest: 8K RAW 50p, C-Log 2 ... High End Video und Foto?

Impressum | slashCAM Homepage | Nutzungsbedingungen | Datenschutzrichtlinie

Rechtliche Notiz:

Wir übernehmen keine Verantwortung für den Inhalt der Beiträge und behalten uns das Recht vor,

Beiträge mit rechtswidrigem oder anstößigem Inhalt zu löschen.