Newsmeldung von slashCAM:

Der Artikel gibt Einblicke in die Arbeit mit dem neuen ACES Academy Color Encoding Specification Farbraum für einen Hollywood Blockbuster wie "Guardians of the Galaxy 2"....

Hier geht es zur Newsmeldung auf den slashCAM Magazin-Seiten:

Hier geht es zur Newsmeldung auf den slashCAM Magazin-Seiten:

Der ACES Workflow in Guardians of the Galaxy 2

Antwort von klusterdegenerierung:

Kann mir mal jemand erklären was der Vorteil daran ist,

wenn ich einen Liter Milch aus der 1 Liter Verpackug in eine 5 Liter Verpackung kippe,

um sie dann wieder zurück in die 1L Verpackung zu kippen?

Antwort von Peppermintpost:

klusterdegenerierung hat geschrieben:

Kann mir mal jemand erklären was der Vorteil daran ist,

wenn ich einen Liter Milch aus der 1 Liter Verpackug in eine 5 Liter Verpackung kippe,

um sie dann wieder zurück in die 1L Verpackung zu kippen?

der vorteil ist du kannst einen milchkipper einstellen und einen 5 liter karton kaufen, schafft arbeitsplätze und macht umsatz.

Antwort von klusterdegenerierung:

Ah, achso, na das ist doch mal was sinnvolles.

Antwort von Peppermintpost:

klusterdegenerierung hat geschrieben:

Ah, achso, na das ist doch mal was sinnvolles.

;-)

Antwort von WoWu:

Wo steht in dem Artikel was von Milch ?

Bist Du im Stadtanzeiger gelandet ?

Ansonsten wirst Du ganz sicher nicht im Farbraum mit dem Umfang arbeiten, den Dein Sensor kann. Du machst also in Deinem bisherigen Workflow zunächst aus 5L einen Liter und kippst 4 Liter weg.

Danach macht es tatsächlich nur noch begrenzt Sinn.

Aber das ist ja in der beschriebenen Produktion auch nicht geschehen.

Aber wer natürlich nur noch einen Liter hat, muss damit klar kommen.

Antwort von klusterdegenerierung:

Wo steht denn dass das so nicht geschehen ist und welche Cam kann denn den vollen Farbumfang aufzeichnen?

Und in so manchem Raw ist ja anscheinend auch nicht mehr das was da eigentlch drin sein müßte, oder?

Antwort von WoWu:

genau das ist ja das Problem, dass RAW meistens gar kein RAW ist und gerade da liegt ja der Vorteil von ACES.

Antwort von Funless:

Ich schmeiß mir jetzt Pommes in den Ofen und guck' Aktenzeichen XY.

Und das ganz ohne Milch.

Antwort von cantsin:

Um im Bild zu bleiben: Bei einer FX-lastigen Großproduktion wird Milch aus allerlei Kartongrößen zusammengerührt. Und dann sorgt man (per ACES) eben für eine Endverarbeitung in Gefäßen, die so groß sind, dass sie die Übermenge aller Kleingefäße bilden, so dass alle Quellen verlustfrei eingerührt werden können.

Antwort von klusterdegenerierung:

Achso, aber gibt es das denn überhaupt, das mehr als ein 1 Liter vorkommt, denn sonnst würde der 1L Karton reichen.

Ich bin jetzt davon ausgegangen das der 1L Karton der 5L ist, da man bei fasst allen Cams eh kaum die 1L erreicht!

@Funless

XY als Unterhaltungsprogramm?

Ihbah, nicht im Ernst?

Antwort von WoWu:

ACES ist hier so oft und ausführlich besprochen worden, dass es mich wirklich wundert, dass immer wieder elementare Fragen kommen.

Suchfunktion gibt es ja wohl noch im neuen Forum ?

Antwort von cantsin:

klusterdegenerierung hat geschrieben:

Achso, aber gibt es das denn überhaupt, das mehr als ein 1 Liter vorkommt, denn sonnst würde der 1L Karton reichen.

Da ist eben Deine Metapher unvollständig. Jede Quelle hat nicht nur eine eigene Milchkartongröße (=Umfang des Farbraums), sondern eine eigene Milchsorte (=Art des Farbraums). Und anders als bei Milch, kann man bei Farben nicht eine Teilmenge abschöpfen, wenn man alle Quellen geschmacksverlustfrei mischen will. Also verwendet man einen großen Bottich wie ACES.

Antwort von Peppermintpost:

lest euch den text nochmal durch. was da promoted wird ist das der kameraman am set seine weitebalance vergurkt, das wird dann in der post wieder raus gerechnet, dann kommen die vfx oben drauf und dann wird auf alles wieder der vergurkte weissabgleich drauf gerechnet bevor es dann ins grading geht wo einer sagt...hmpf... das ist mir aber irgendwie zu grün... und dann das damit macht wozu er gerade bock hat. dieser workflow wird gerade als die neue sau durchs dorf getrieben.

den vorteil kann ich da echt nicht sehen, aber darum gehts ja offensichtlich auch nicht. ich kann klusters kritik da sehr gut nachvollziehen.

Antwort von klusterdegenerierung:

Da hast Du nicht richtig gelesen!

Das ACES die 5L sind ist mir auch klar und genauso der Vorteil darin,

ist ja keine Kunst das zu verstehen!

Aber um mal beim Vergleich zu bleiben, was nützt mir ein Gerät was 800ml ausgibt und ich es in ein 5L Gefäß kippe?

900ml bleiben 900ml.

Antwort von WoWu:

Ist ja nicht der Fall, denn die Ausgangsbasis sind in der Produktion ja die 5L.

Was Du hinterher daraus machst, hängt ja von den Zielvorgaben ab.

Antwort von cantsin:

klusterdegenerierung hat geschrieben:

Aber um mal beim Vergleich zu bleiben, was nützt mir ein Gerät was 800ml ausgibt und ich es in ein 5L Gefäß kippe?

900ml bleiben 900ml.

Du hast aber nicht nur ein Gerät, das 800ml ausgibt, sondern lauter Geräte, die alles mögliche ausgeben. Und selbst wenn Deine Sony in Slog 800ml ausgibt, sind das andere 800ml als die einer Canon, die in Rec709 oder CLog filmt. Du brauchst also schon 1600ml, um das Material zusammenzurühren. Und statt für jedes Projekt die jeweilige Farbraum-Übermenge aller verwendeten Bildquellen neu zu definieren, nimmt man eben einen Mega-Farbraum, in dem alles Platz finden kann.

Bei einem Film wie Guardians of the Galaxy sind die Bildquellen mindestens die RED Weapon und die aufwändigen VFX, wahrscheinlich aber noch mehr.

Antwort von WoWu:

Ist doch auch gar nicht der Fall.

Für die RED Anteile des Contents (die zweifellos den Engpass darstellen) wurde IPP2 benutzt.

Wo ist da die Rede von (800 ml) ?

Völliger Quatsch.

Antwort von klusterdegenerierung:

cantsin hat geschrieben:

klusterdegenerierung hat geschrieben:

Aber um mal beim Vergleich zu bleiben, was nützt mir ein Gerät was 800ml ausgibt und ich es in ein 5L Gefäß kippe?

900ml bleiben 900ml.

Du hast aber nicht nur ein Gerät, das 800ml ausgibt, sondern lauter Geräte, die alles mögliche ausgeben. Und selbst wenn Deine Sony in Slog 800ml ausgibt, sind das andere 800ml als die einer Canon, die in Rec709 oder CLog filmt. Du brauchst also schon 1600ml, um das Material zusammenzurühren. Und statt für jedes Projekt die jeweilige Farbraum-Übermenge aller verwendeten Bildquellen neu zu definieren, nimmt man eben einen Mega-Farbraum, in dem alles Platz finden kann.

Bei einem Film wie Guardians of the Galaxy sind die Bildquellen mindestens die RED Weapon und die aufwändigen VFX, wahrscheinlich aber noch mehr.

Ne 800ml plus 800ml sind immer noch 800ml, wenn es die gleichen sind.

Sonst müßte ich ja für eine ganze Timeline verschiedener Cams 2x ACES haben!

Antwort von cantsin:

Korrekt wäre wohl eher die Analogie von ACES=5 Liter und RED IPP2=4 Liter.

Antwort von klusterdegenerierung:

WoWu hat geschrieben:

Ist doch auch gar nicht der Fall.

Für die RED Anteile des Contents (die zweifellos den Engpass darstellen) wurde IPP2 benutzt.

Wo ist da die Rede von (800 ml) ?

Völliger Quatsch.

Ne Du hast ja Recht wenn eine Red etc. 5L ausgeben kann, macht ACES natürlich richtig Sinn,

aber ich war auf dem Stand, das eh kaum eine Cam mehr als 1L ausgibt, da ich dachte sie liegen alle im selben Bereich.

Das hiese ja, es gibt Cams die ACES ausgeben, oder so raw das man es hinterher in alles packen kann was man so möchte bzw braucht.

Antwort von klusterdegenerierung:

cantsin hat geschrieben:

Korrekt wäre wohl eher die Analogie von ACES=5 Liter und RED IPP2=4 Liter.

Jo, das wäre eine Maßnahme, dann ist 709 bestimmt 800ml! ;-)

Antwort von Peppermintpost:

WoWu hat geschrieben:

Ist ja nicht der Fall, denn die Ausgangsbasis sind in der Produktion ja die 5L.

Was Du hinterher daraus machst, hängt ja von den Zielvorgaben ab.

wowu aber genau das ist ja eine der schwachsinns geschichten. klar kann ich in der post einen unendlichen wertebereich abbilden, aber am ende sende ich das material doch nicht per elektronischem implantat auf die hirnrinde sondern schaue es auf einem monitor oder im kino. beide darstellungsformen sind dem was die kamera aufzeichnet doch schon meilenweit unterlegen, das bedeutet ich muss mein material soweso massiv eindampfen um es darstellen zu können. ich habe bei weitem nichts gegen etwas headroom in der post, aber irgendwie wird das alles doch inzwischen einfach nur noch gemacht weil man es kann, sinnhaftigkeit ist da kaum noch zu finden. bei absoluten extremen evtl wie eine verchromte ritterrüstung in praller wüstensonne, da würde ich es ja gelten lassen, aber allen ernstes, die jungs drehen 90% der zeit vor grün im studio und machen dann auf dicke hose wie sie da angeblich technisch was ausreitzen was am ende keinen sinn macht und schon garnicht beim zuschauer ankommt.

Antwort von cantsin:

klusterdegenerierung hat geschrieben:

Ne 800ml plus 800ml sind immer noch 800ml, wenn es die gleichen sind.

Sonst müßte ich ja für eine ganze Timeline verschiedener Cams 2x ACES haben!

Nein, Du verstehst es einfach nicht. Nimm die Analogie von Farbtuben. Du hast acht 100ml Farbtuben mit verschiedenen Regenbogen-Farben, und du hast acht 100ml Farbtuben eines anderen Herstellers, die zwar auch den Regenbogen abbilden, aber in anderen Farbschattierungen/-tönen.

Wenn Du jetzt die Farben nebeneinander verwendest, brauchst eine größere Palette - und zwar mit 16 Farbtöpfen.

ACES ist eine Riesenpalette, in der alle Farbtöne aller Hersteller Platz haben. Du brauchst also nicht 2x ACES, sondern nur diese eine Groß-Palette.

Antwort von WoWu:

damit dürfte das 1L Thema wohl vom Tisch sein.

Antwort von cantsin:

Peppermintpost hat geschrieben:

klar kann ich in der post einen unendlichen wertebereich abbilden, aber am ende sende ich das material doch nicht per elektronischem implantat auf die hirnrinde sondern schaue es auf einem monitor oder im kino.

Aber genau da liegt doch das Problem, weil das Kino z.B. P3-Farbraum hat und der Monitor RGB bzw. der Fernseher Rec709. Und in der Zukunft gibt's - dank neuer Displaytechniken - auf Endgeräten vielleicht Farbräume, die heute noch gar nicht definiert sind.

Der beste Master ist doch der, in dem der Farbraum so großzügig dimensioniert bzw. flexibel ist, dass in der Post möglichst nichts beschnitten wird und man in die kleineren Farbräume 'runterkonvertieren kann, statt Material von einem kleineren Farbraum in einen anderen kleineren Farbraum (z.B. mit LUTs) verlustbehaftet zu übersetzen.

EDIT: In diesem Sinne ist ACES in Bezug auf Farbräume/Farbverarbeitung exzellent vergleichbar mit Unicode/UTF-8 bei Schriften bzw. Schriftcodierungen. Vor Unicode musste man Texte noch von ASCII nach Latin1 etc. konvertieren (genauso, wie LUTs das heute mit Farbräumen machen) bzw. für außereuropäische Sprachen Spezialfonts verwenden, was regelmäßig zu Darstellungsfehlern auf Computern führte, die diese Fonts nicht hatten. Seit Unicode muss man sich glücklicherweise um diesen Kram nicht mehr kümmern.

Antwort von klusterdegenerierung:

Ja ja Jungs, ist ja gut! ;-)

Sorry, ich dachte halt zb. 2x RGB Farbraum, egal wie der ausgereizt ist, entschpricht trotzdem DEM RGB Farbschema,

ob jetzt ein Bild nur 70% davon nutzt und ein anderes nur 40, weil es fasst nur blau enthält, ist es trotzdem NUR RGB,

weil eben genau dieses Blau enthält, welches ja im RGB Raum aufgenommen wurde, da passen dann beide Rein.

Es sei denn man packt ein Adobe dazu, welches in bestimmten Bereichen garnicht darein passt,

da macht dann ein größerer Raum mehr Sinn, denn das Magenta aus dem Adobe Raum passt ja nicht in den RGB Raum!

Antwort von cantsin:

klusterdegenerierung hat geschrieben:

Ja ja Jungs, ist ja gut! ;-)

Sorry, ich dachte halt zb. 2x RGB Farbraum, egal wie der ausgereizt ist, entschpricht trotzdem DEM RGB Farbschema,

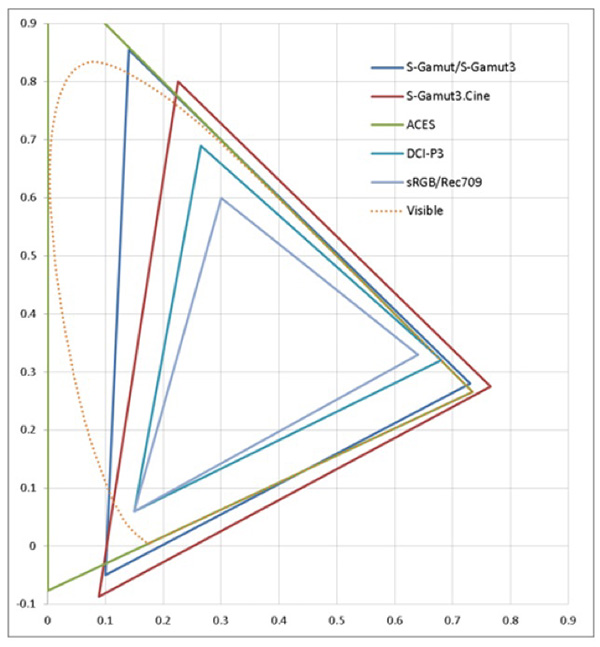

Aber schon das SLog Deiner Sony A6300/6500 (grünes Dreieck in der Abbildung unten) liegt weit ausserhalb RGB (weisses Dreieck):

zum Bild

Antwort von klusterdegenerierung:

Schon klar, aber auch wenn ich zehn a6300 benutze und dazu noch meine FS700,

braucht man dafür lange kein ACES, weil das alles noch in das passt, womit es auch ausgegeben wurde. ;-)

Antwort von WoWu:

Dann hast Du den Sinn von ACES noch nicht verstanden.

Aber Du hast natürlich Recht, wer 709 aufnimmt und nur auf seinem 709 TV wiedergibt, braucht kein ACES sondern nur ein Kabel.

Aber was hat das mit dem hier geposteten Thema zu tun ?

Antwort von Funless:

klusterdegenerierung hat geschrieben:

@Funless

XY als Unterhaltungsprogramm?

Ihbah, nicht im Ernst?

Nee Nee, definitiv nicht als Unterhaltungsprogramm. Das war es noch nie für mich.

Btw danke an alle hier im Thread für Eure Diskussion. Ich muss gestehen, dass mir die ACES Geschichte bisher mehr wie ein Buch mit sieben Siegeln vorkam, mir fehlt da wahrscheinlich der ausreichende technisch-akademische Background hierfür. Doch dank Eurer Milchanalogie ist mir die Thematik jetzt viel schlüssiger.

Antwort von klusterdegenerierung:

WoWu hat geschrieben:

Dann hast Du den Sinn von ACES noch nicht verstanden.

Aber Du hast natürlich Recht, wer 709 aufnimmt und nur auf seinem 709 TV wiedergibt, braucht kein ACES sondern nur ein Kabel.

Aber was hat das mit dem hier geposteten Thema zu tun ?

Doch doch, türlich habe ich es verstanden, aber ich habe mir gedacht, das sobald ich Farben verwende, die eine Summe der anderen sind,

komme ich nicht über ein bestimmtes Maß hinaus, auch wenn sie aus unterschiedlichen Farbräumen kommen.

Ich bekomme ja auch einen halben Liter Buttermilch in meinen Liter Karton! ;-) Sorry der war jetzt nur zur belustigung für Funless! ;-))

Antwort von WoWu:

Selbst wenn dem so ist, Du also Signale unterschiedlicher Kameras, aus unterschiedlichen Farbräumen in einer Produktion nutzen willst, ohne Dich für einen bestimmten Farbraum entscheiden zu wollen und damit höherwertige Farbräume durch Konversion zerdepperst, bietet sich ACES als übergeordneter Workflow geradezu an (solange Du nicht nur Kindergebirtstag machst und mit Buttermilch auskommst).

Antwort von klusterdegenerierung:

Ok, das heißt in Summe, 1L Ziegenmilch + 1L Kuhmilch + 1L Buttermilch + 1L Laktosefrei ergeben am Ende doch 4 L Flüßigkeit

und nicht 1L Milch aus verschiedenen Sorten! ;-))

Muß ich dann in Resolve nur mein Projekt in ACES anlegen und alles reinschaufeln, oder muß ich dann noch nen anderen Zampano machen?

Antwort von WoWu:

Anders als Funless halte ich den Vergleich für absolut ideotisch, weil wir es hier nicht mit Mengen, sondern Qualitäten zu tun haben.

Und das gerade angeführte Beispiel widerlegt Deine Ansicht, dass Du es verstanden hättest.

Aber auch, dass gar kein echtes Interesse besteht "Zampano" zu machen.

Mach einfach weiter dein graues LOG und gut is'.

Antwort von klusterdegenerierung:

Man WoWu, Du mußt auch mal einen Spass machen! Komm man ;-)

Hab das schon wohl verstanden, aber ich war echt der Meinung, das auch wenn ich 709 und Slog und 2020 mit gleichem Inhalt mische, ich nicht über ein bestimmtes Maß hinaus komme, bei dem ich am Ende ein weitausgrößeren Raum brauche, als die Summe aus der vergleichbaren Menge.

Aber dem ist wohl nicht so und man kann sagen, das schon jeder Frbraum für sich, selbst wenn er den gleichen Inhalt hat,

nicht mit einen aus diesen Räumen alleine passen würde.

Antwort von Funless:

Also ich habe mir jetzt nochmal den

slashCAM Artikel von damals durchgelesen und im Fazit steht als letzte Anmerkung:

ACES ist das kommende, normierte RAW, aber hierzu bedarf es noch weiterer Grundlagen(-Artikel).

Trifft diese Aussage vom Prinzip her den Punkt? Ein einfaches "ja" oder "nein" reicht mir.

Und meine Danksagung vorhin war Ernst und nicht sarkastisch gemeint. Da für mich das alles eher im theoretischen liegt, resultierend fehlender Anwendungsfälle, habe ich eben auch ein bisschen Probleme das ganze zu Erfassen. Und da können solch Analogien (Michmenge/Milchsorten) für solche wie mich schon hilfreich sein. Wenn es weniger idiotische Vergleiche geben sollte, gerne immer her damit.

Antwort von j.t.jefferson:

WoWu hat geschrieben:

Ist doch auch gar nicht der Fall.

Für die RED Anteile des Contents (die zweifellos den Engpass darstellen) wurde IPP2 benutzt.

Wo ist da die Rede von (800 ml) ?

Völliger Quatsch.

da gabs noch kein IPP2.

Gibts auch erst seit kurzem.

Antwort von WoWu:

Offenbar hast Du den verlinkten Originalartikel gar nicht gelesen.

@Funless

Antwort ist "ja", obwohl es kein RAW ist, was im ACES Workflow zur Anwendung kommt ...

Aber es kommt immer darauf an, wie viele Hersteller es unterstützen, denn den eigentlichen Vorzug von ACES hat man erst, wenn das Kameravideo auch vom Hersteller im dem Format (IDT) übertragen wird.

Erst dann hat es Qualitäten, ähnlich einem RAW.

Antwort von Funless:

WoWu hat geschrieben:

@Funless

Antwort ist "ja", obwohl es kein RAW ist, was im ACES Workflow zur Anwendung kommt ...

Aber es kommt immer darauf an, wie viele Hersteller es unterstützen, denn den eigentlichen Vorzug von ACES hat man erst, wenn das Kameravideo auch vom Hersteller im dem Format (IDT) übertragen wird.

Erst dann hat es Qualitäten, ähnlich einem RAW.

Vielen Dank, jetzt machen die Zusammenhänge Sinn für mich und ich beginne es zu verstehen.

Antwort von motiongroup:

Was geschieht eigentlich unabhängig davon wo genau der Liter Molke sich im 5 Liter Butterfass nun aufhält mit den Teilen Sonys S-Log die nicht im Aces Bereich abgedeckt sind....

Antwort von wolfgang:

WoWu hat geschrieben:

Anders als Funless halte ich den Vergleich für absolut ideotisch, weil wir es hier nicht mit Mengen, sondern Qualitäten zu tun haben.

Und das gerade angeführte Beispiel widerlegt Deine Ansicht, dass Du es verstanden hättest.

Aber auch, dass gar kein echtes Interesse besteht "Zampano" zu machen.

Mach einfach weiter dein graues LOG und gut is'.

Es stimmt, Cluster hat denn Sinn der Nutzung eines übergeordneten Farbraums für das Zusammenkochen der Suppe noch nicht verstanden. Nur gehts dich weniger um log sondern eher doch darum, welchen Farbumfang der Sensor und die Kamera tatsächlich aufzeichnen kann, und dass der entsprechend erhalten bleibt und nicht in der Post beschnitten wird.

Der Sinn, beim Dreh auf exotische Farben durch Anpassung der Kamera zu gehen, und dann in der Postpro-Küche lediglich einen ausreichen großen ACES-Kochtopf zu nehmen um das wieder (ohne Farbbeschneidungen) rausdrehen zu können, denn Sinn sehe ich auch noch nicht.

Antwort von Bergspetzl:

Gehe ich davon aus, dass ich das alles falsch verstehe, oder denkt man hier schlicht zu kompliziert?

Wenn der Kameramann am Set seine Farben verdreht und damit aufnimmt, dann macht das für mich irgendwie Sinn, denn:

Wenn der Tint Richtung Grün geht, dann foliert er sein Licht vielleicht eher Richtung Magenta, um irgendwo eine Art von Weiß zu Erhalten, an anderer Stelle im Bild tritt aber der Tint zu Tage, die Aufnahme ist auf jeden Fall verdreht, egal wohin man jetzt geht....

Wenn er halbwegs bei seinem "Lut" bleibt und daraufhin einleuchtet und künstlerische Entscheidungen trifft, dann sind diese doch im Bild eingebacken, auch wenn erstmal das Material "neutral" in die Pipline geht. Die Farbstiche sind ja jetzt da. Das sie dann in der Post anfangen, den "Lut/Look" zurück zu nehmen und dann "richtig" aufbauen, inkl. VFX usw. macht ja Sinn. Der ACES Farbraum ist dabei ja nur von Vorteil.

Oder versthe ich da was nicht

Antwort von wolfgang:

Wurde hier über Lichtsetzung gesprochen - das macht natürlich gestalterisch Sinn. Oder ist es nur das Verdrehen der Kameraparameter? Das würde für mich weniger Sinn machen - denn einen ausreichend hichwertigen codec vorausgesetzt mache ich das lieber in der Post.

Das meinte ich, mir erschließt sich der Sinn für eine Kinoproduktion noch nicht (die ja wohl umfangreich gegraded wird).

Antwort von cantsin:

Bergspetzl hat geschrieben:

Wenn er halbwegs bei seinem "Lut" bleibt und daraufhin einleuchtet und künstlerische Entscheidungen trifft, dann sind diese doch im Bild eingebacken, auch wenn erstmal das Material "neutral" in die Pipline geht. Die Farbstiche sind ja jetzt da. Das sie dann in der Post anfangen, den "Lut/Look" zurück zu nehmen und dann "richtig" aufbauen, inkl. VFX usw. macht ja Sinn. Der ACES Farbraum ist dabei ja nur von Vorteil.

Ja, genau - das ist der ganze Punkt dieses Workflows. Man geht weg von der Idee, möglichst neutrales Material für die Post anzuliefern (um den Farblook in der Software zu bauen), sondern nimmt sich die Freiheit, schon am Set den Look/Farbstich zu leuchten. ACES hilft dabei, dass (a) trotzdem genug Spielraum für die nachträgliche Farbkorrektur bleibt, (b) weniger Probleme bei der Mischung dieses "vorgegradeten" Materials entstehen, wenn es mit verschiedenen Kameras aufgenommen wurden bzw. aus verschiedenen Quellen stammt.

Antwort von wolfgang:

Kann man ja alles machen, sich diese Freiheit nehmen. Nur wozu?

Antwort von cantsin:

wolfgang hat geschrieben:

Kann man ja alles machen, sich diese Freiheit nehmen. Nur wozu?

Zum Beispiel, um die beabsichtigte Lichtstimmung schon am Set zu haben und so die Schauspieler besser in ihre Rollen eintauchen und lebendiger agieren zu lassen. Gerade bei SFX-lastigen Filmen nicht verkehrt (man denke nur an die 90er Jahre Star Wars-Prequels als abschreckendes Gegenbeispiel).

Antwort von stip:

Welche oder wieviel Milch man am Ende auch hat, sie ist ja nur ein kleiner Teil aller Zutaten des Rezeptes. Manchmal ist auch Wasser statt Milch besser. Man kann natürlich auch den ganzen Tag die perfekte Milch suchen - solange es am Ende schmeckt geht vieles.

Antwort von wolfgang:

cantsin hat geschrieben:

wolfgang hat geschrieben:

Kann man ja alles machen, sich diese Freiheit nehmen. Nur wozu?

Zum Beispiel, um die beabsichtigte Lichtstimmung schon am Set zu haben und so die Schauspieler besser in ihre Rollen eintauchen und lebendiger agieren zu lassen. Gerade bei SFX-lastigen Filmen nicht verkehrt (man denke nur an die 90er Jahre Star Wars-Prequels als abschreckendes Gegenbeispiel).

Ja schon, und wenn es Lichtstimmung wäre dann bin ich sofort bei dir. Aber hier redet ja der Bericht nur von Manipulation von Farbtemeratur und Tint an der Kamera, sonst aber von nichts. Und das mache ich eigentlich besser in der Post.

Antwort von Frank Glencairn:

Aces macht nur Sinn, wenn man mit verschiedenen Kameras dreht - und selbst da muss man trotzdem noch per Hand rum schrauben, um z.B. ne Alexa und ne Red gematcht zu bekommen - Aces ist keine One Button Wunderkiste, sondern gibt dir bestenfalls einen Startpunkt, um verschiedene Kameras anzugleichen.

Das ganze ist ne nette Idee, und funktioniert auch halbwegs, wird aber insgesamt überschätzt.

Der Satz " ACES ist das kommende, normierte RAW" ist ziemlich bizarr, weil ACES ein Farbraum ist, und raw sind undebaierte Daten. Das eine hat mit dem anderen überhaupt nix zu tun.

Letztendlich ist Aces nur ein Farbraum, den man so groß gemacht hat, daß alle anderen bequem rein passen. Im Aces Workflow, wird dann versucht, Material aus unterschiedlichen Quellen mit LUTs aneinander anzugleichen - was wie schon gesagt, nur bedingt funktioniert, weil man halt Material aus einer GoPro oder DSLR (um jetzt mal ein Extrembeispiel zu nehmen), halt nicht per ACES auf Alexa Niveau heben kann.

Antwort von wolfgang:

Frank, ACES ist doch mal zunächst nur ein großer Farbraum. Da bin ich bei dir. Der einfach so groß ist dass mal alles rein paßt.

Bereits das Argument, dass dies für verschiedene Kameras gut sei - das würde nur wesentlich sein wenn verwendete Farbräume von verschiedenen Kameras enorm unterschiedlich wären. Das bezweifle ich aber bereits sehr. Die traurige Wahrheit ist heute zumindest noch eher die, dass Kameras wie Sichtgeräte heute erste einen Bruchteil der größeren Farbräume abdecken. Bei den UHD-TVs sind wir in der Gegend von DCI, und selbst wenn Kameras in Farbräumen wie neuerdings rec2020 aufzeichnen heißt das noch nicht dass die diesen Umfang wirklich nutzen. Frage - kennt da wer gute Untersuchungen wie viel die heute gängigen Kameras tatsächlich von den Farbräumen abdecken?

Was ein Farbraum wieder mit raw zu tun hat, weiß ich auch nicht. Ein Format ist doch nur der Container in dem der Farbraum abgebildet wird. Aber ich bin ja nur dummer Praktiker.

Antwort von cantsin:

wolfgang hat geschrieben:

Bereits das Argument, dass dies für verschiedene Kameras gut sei - das würde nur wesentlich sein wenn verwendete Farbräume von verschiedenen Kameras enorm unterschiedlich wären. Das bezweifle ich aber bereits sehr. Die traurige Wahrheit ist heute zumindest noch eher die, dass Kameras wie Sichtgeräte heute erste einen Bruchteil der größeren Farbräume abdecken.

Das stimmt zwar, ändert aber nichts daran, dass fast jeder Hersteller sein eigenes Farbraum-Süppchen kocht und man zwischen den Farbräumen hin- und herkonvertieren muss. (Was ja nicht nur Coloristen in der Kino-Postproduktion beschäftigt, sondern mittlerweile auch Videoamateure, die z.B. Slog-Material aus einer RX100 mit RGB- oder VLog-Material einer GH4/5 in einer Timeline verarbeiten.)

Hier greift wieder die Analogie zu den Schriftcodierungen: Wenn jedes Textverarbeitungsprogramm und Betriebssystem das Alphabet anders codieren würde (wie noch in der Vergangenheit), müsste man ohne einen allgemeinen Standard selbst dann permanent umcodieren, wenn 90% der Textdateien nur das lateinische Alphabet verwenden. Wenn man dann aber so einen allgemeinen Standard schafft, dann so, dass möglichst alle Alphabete darin Platz haben.

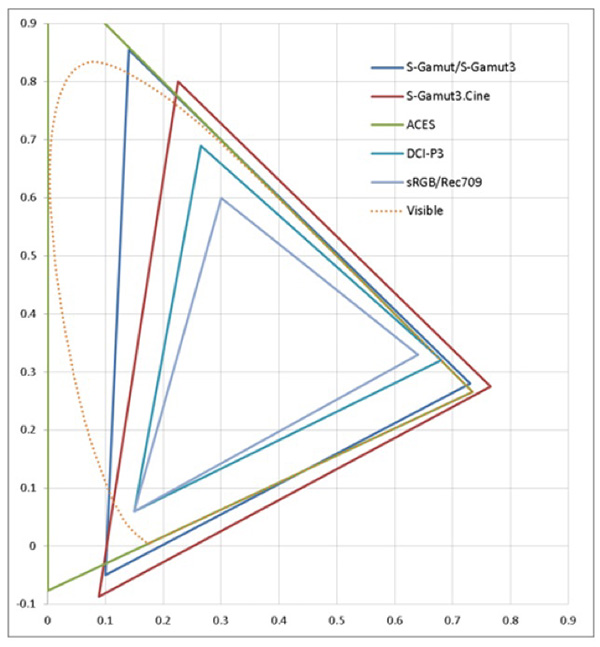

Bezogen auf Farbräume ist das eben ACES. Mag sein, dass die meisten heutigen Kamerasensoren nur einen Bruchteil davon abdecken, aber das ändert sich schon bei Filmscans:

zum Bild

zum Bild

...wobei das Schaubild oben nur Kopierfilm spezifiziert, nicht z.B. Kodachrome mit seinem extremen Farbraum.

EDIT: Und hier noch ein Plotdiagram für den Farbraum eines gescannten, handelsüblichen Diafilms:

zum Bild

Antwort von wolfgang:

Alles richtig, allerdings ist viel zu wenig dokumentiert welcher Teil des ACES Farbraums tatsächlich zB von einer FS7 oder GH4/5 genutzt werden. Das ist etwa eine Gerätekombination die einige an HDR interessierte durchaus nutzen. Klar kann man sagen, ist alles egal, nutze ACES und gut ist es. Ich vermute s-gamut würde etwa auch reichen.

Antwort von WoWu:

Es ist eben ein Trugschluss, ACES lediglich auf den Umfang des Farbraums zu reduzieren.

Der Farbraum ist zwar das Kernstück von ACES aber schon die Linearität weicht von bisherigen Verfahren ab, die dann erst( und immer wieder) gewandelt werden müssen.

Wer nicht den gesamten Workflow von ACES betrachtet, erkennt auch nicht die Vorteile.

Daraus folgt dann, die Reduzierung auf den Farbraum, die der Sache nicht annähernd gerecht wird.

Aber, wie gesagt, nicht jeder hat den Bedarf.

Kamera raus ... TV rein, reicht ein Kabel.

Aber das ist auch nicht Gegenstand des Titels.

Antwort von cantsin:

wolfgang hat geschrieben:

Klar kann man sagen, ist alles egal, nutze ACES und gut ist es. Ich vermute s-gamut würde etwa auch reichen.

Dieser Artikel erklärt, warum das Probleme schaffen kann:

http://www.xdcam-user.com/2014/05/what- ... -about-it/

S-Gamut ist nicht als "ACES Light" konzipiert.

Antwort von wolfgang:

Na wenn man etwa den Catalyst Prepare von Sony verwendet, dann erledigt der das Grading von S-Gamut.cine oder S-Gamut zu DCI P3 oder rec709. Der kann auch einen ACES workflow und ich gehen mal davon aus, dass das Material von dem tool korrekt umgerechnet wird. Eine andere Alternative ist Resolve.

Die spannendere Frage wird aber HDR aufwerfen, denn dort gradest nicht mehr zu rec709.

Antwort von Starshine Pictures:

Gibt es denn irgendwo eine Liste von Kameras die ACES kompatibel sind? Von Canon sind das eben nur die C300 (I+II) und die C700.

Antwort von Paralkar:

Aces wird hier irgendwie überhaupt nicht richtig verstanden, oder vielleicht doch und ich bin bei der Milchanalogie ausgestiegen, who knows.

Aces bringt erstmal den Vorteil ungefähr alles was jemals darstellbar/erfassbar sein wird vergleichbar zu machen und mit dem richtigen IDT(s) gleich weitestgehend kompatibel zu machen in Punkte Farben/ Farbraum (klar wird ne Alexa weiterhin anders aussehen als ne FS7 oder ne Dragon)

Wesentlicher Vorteil ist jedoch die ODTs (Output Device Transform), das bedeutet, etwas das in Aces gemastert wird, kann in Zukunft selbst in 10 jahren in den Farbraum Rec 2500 konvertiert werden. Klar müssen wir realistisch dabei bleiben ne Kamera die nur P3 abbildet wird durch Aces nicht anfangen mehr Informationen zu bekommen.

Was ich mich bei dem Workflow fragen, warum ne CDL, es ist doch super begrenzt mit SOP, warum keine gescheite LUT oder bei so nem Projekt Daylight/ Baselight Workflow oder sonst was...

Aces Kompatibel bedeutet das der Kamerahersteller auch IDTs entwickelt hat für die Kamera, tendenziell kannst du alles in Aces bringen.

Antwort von Funless:

Paralkar hat geschrieben:

... tendenziell kannst du alles in Aces bringen.

Auch "smoking Aces"?

Antwort von Starshine Pictures:

Klar. Wobei ich eher glaub dass da die Academy die Kameras prüft und die spezifischen IDT's erstellt. Und das meinte ich: Welche Kameras wurden geprüft und haben einen IDT bei der Academy rum liegen?

Antwort von Alf_300:

Ich möchte natürlich auch so einen tollen Codec nutzen

Was brauch ich denn zusätzlich an Hardware ?

Antwort von WoWu:

"Starshine Pictures" hat geschrieben:

Klar. Wobei ich eher glaub dass da die Academy die Kameras prüft und die spezifischen IDT's erstellt. Und das meinte ich: Welche Kameras wurden geprüft und haben einen IDT bei der Academy rum liegen?

Genau das eben nicht.

RAW wurde von so wenigen Herstellern unterstützt, weil sie in den Metadaten Rückschlüsse über ihre Verfahren hätten preisgegeben.

Genau das wird in ACES verhindert, weil all die Einzelheiten in die IDT einfließen und ihre Verfahren damit nicht offen liegen, aber so quasi ein identischer Nutzeffekt, wie in RAW entsteht.

Die academy prüft nix und stellt auch nix her.

Normiert würde das Verfahren ohnehin von der SMPTE.

"tendenziell kannst du alles in Aces bringen."

Im Prinzip ja, allerdings nur noch mit begrenztem Nährwert, denn wenn ein nicht lineares Signal von 8Bit wieder linearisiert in ein 16 Bit Word gepackt wird, ist nicht mehr viel davon übrig und bis auf die Kompatibilität zu andern Signalen geht der qualitätsbringende Effekt des IDTs verloren.

Das wäre dann so, alswenn man RAW ERST ZU 709 macht und es dann mit andern RAW formaten mischt und hofft, dass man keinen Unterschied mehr sieht, wenn das Zielprodukt 10Bit DCI ist.

Antwort von Paralkar:

Deswegen hat gopro wahr. keine Gopro 5 (is das die neuste?) IDT rausgebracht.

Der ganze Workflow macht keinesfalls für jeden und für jede kleine Postpro Sinn, für Youtube oder Internetfilmchen oder sonst was. Aber bei nem so teuren und großen Kinofilm mit soviel VFX und allem kann das schon sinn machen.

Die VFXler haben bis jetzt ja immer Log bekommen und dann ne Lut für ihre Preview draufgelegt, gebastelt und dann wieder ohne Lut in Log zurück...

Der damalige Colorist in der Postpro, wo ich angefangen hatte zu lernen, hat die Einzelbildsequenzen für die VFX immer selbst gerechnet, weil er schiss hatte das irgendjemand farb oder gamma infos verhaut

Alles perse mit Aces

Antwort von Frank Glencairn:

"Starshine Pictures" hat geschrieben:

Klar. Wobei ich eher glaub dass da die Academy die Kameras prüft und die spezifischen IDT's erstellt. Und das meinte ich: Welche Kameras wurden geprüft und haben einen IDT bei der Academy rum liegen?

Die Academy macht da gar nix.

Einfach ein Programm aufmachen, das Aces kann, und in der IDT Liste nachsehen, welche Kameras unterstützt werden.

Alf_300 hat geschrieben:

Ich möchte natürlich auch so einen tollen Codec nutzen

Codec?

Und das nach 2 Seiten. Facepalm.

Antwort von WoWu:

@paralkar

Da bin ich völlig bei Dir.

Nur reicht eben auch für 90% aller Internetfilmchen 709 und trotzdem ist LOG zum Hype geworden, obwohl die meisten es gar nicht beherrschen.

Das wird wohl mit ACES ähnlich aussehen, nur dass da nicht so viele selbstgebastelten LUTs drin vorkommen und Bilder besser reproduziert werden können, auch weil es mittlerweile einen gut beschriebenen Standard dafür gibt ... aber selbst das bleibt abzuwarten.

Antwort von Paralkar:

hmm da bin ich nicht ganz deiner Meinung, da wenn du Log aufzeichnest mit ner LUT immer in Rec 709 kannst, aber halt nicht andersrum wenn du in 709 aufgezeichnet hast.

Klar kann man sihc jetzt streiten über 8 bit log, weil die Tonwertverteilung dadurch "gefährlich" wird, aber in 10 bit n Log, anstatt n 709, um nicht gleich alles ausgebrannt zu haben, sobald man mal Kontrast im Bild hat, finde ich schon sehr sinnvoll. Das ist jetzt meine Sicht als DIT & Colorist, ob des auf nem Eventfilm sein muss, kann man sich streiten, aber selbst da bleibt der Vorteil, eine Richtung geht, die andere nicht.

Klar können die wenigsten professionell graden, aber durch den Highlight Regler in Davinci können sie am Ende mittels log doch noch Sachen erreichen, die im 709 nicht klappen würden.

Aber ich versteh schon was du sagen willst.

Sagmal hat ne IDT eigentlich auch so "Stützpunkte" wie ne LUT oder is das anders zu betrachten?

Antwort von wolfgang:

Jetzt macht euch nicht gleich ins Hemd, Ladies. ;) Mit tools wie dem Catalyst ist der ACES workflow überschaubar einfach, Schwerpunkt auf Sony footage die automatisch erkannt wird. Und auch für Resolve finden sich relativ einfache Tutorials mit Kochrezepten im Netz.

https://mixinglight.com/color-tutorial/ ... know-aces/

Das wird sich beherrschen lassen, auch mit beschränktem Theoriewissen.

Antwort von Frank Glencairn:

Wie schon gesagt, ist das sowieso nur ein Thema, wenn man mit verschiedenen Kameras gleichzeitig dreht.

Antwort von WoWu:

@Paralka

Stützstellen bringen nichts bei der Übergabe eines Signals in einen linearen workflow weil es darum geht, die kameraspezifischen Eigenschaften, die primär in der Hardware festliegen ( und nur dem Hersteller bekannt sind) möglichst genau zu übergeben.

Das ist ja gerade der Kritikpunkt der Hersteller bei RAW, dass sie ( nur als Beispiel) die genaue Farb-Überlappungsbreite der Mosaikfilter preisgeben müssten (und diverse andere Eigenschaften des Prozesses).

Insofern ist es im hohen Interesse der Hersteller, die IDTs geschlossen zu halten, weil sie zum Qualitätsmerkmal der. Kamera gehören.

Jeder Hersteller wäre ja mit dem Klammerbeutel gepudert, wenn er veränderliche Stützstellen anböte und damit sein Produkt zur qualitativen Wundertüte machte.

Antwort von stip:

Alf_300 hat geschrieben:

Ich möchte natürlich auch so einen tollen Codec nutzen

Was brauch ich denn zusätzlich an Hardware ?

Da wirst du wahrscheinlich tatsächlich aufrüsten müssen. Der ACES Codec ist sehr CPU, GPU, RAM, MfG und FdH hungrig. Da müsste schon die neueste Generation von Gear her - dafür bekommst du dann aber ziemlich gute Ergebnisse quasi auf Knopfdruck. Ziel des ACES Codecs bei dessen Konzeption war ja, dass er den Filmlook als Basis implementiert, egal welche Kameras reingeschmissen werden. Allerdings wie gesagt nur mit Hilfe der neuesten Technik und teurer Ausrüstung: da muss man einfach mal in den sauren Apfel beissen und sich ein paar Wochen online mit Gear beschäftigen. Apropos saurer Apfel, der ACES Codec läuft leider noch nicht unter MAC OS. Was aber nicht soo schlimm ist, da mit jedem Update des ACES Codecs (ca alle 3 Monate) ohnehin auch die Hardware ausgewechselt werden muss, in der Regel auf das Allerneueste, das es gerade gibt. Die Frage ist eben, ob sich das lohnt für Youtube Filme. Ich meine nein, denn der Nachfolger, BCES, ist schon angekündigt und sollte ACES nochnmal übertreffen. In was genau übertreffen weiss ich jetzt nicht, aber ich warte lieber darauf und mache in der Zwischenzeit gar nichts.

|

Antwort von WoWu:

Hääää ?

ACES ist kein Codec sondern ein Workflow.

Und Dein "Nachfolger" BCES ist ein MPEG2 Derivat.

Vielleicht solltest Du nochmal in die Materie einsteigen und deine Kenntnis nicht aus Blogs beziehen.

Antwort von stip:

ach WoWu ;)

Antwort von Paralkar:

er trolled einfach gerne,

@frank genau das stimmt eben nicht, sorry aber verbreitet doch keine Falschinformationen oder bleibt doch nicht immer bei einem Standpunkt, wenn jemand schon genügend Argumente geliefert hat, die dem komplett widersprechen. Aces macht genauso Sinn, wenn du mit nur einer einzelnen Kamera drehst, weil du dank der ODT (Output Device Transform) dein Projekt zukunftsorientiert in jeden Farbraum mastern kannst. Sprich du brauchst n 709 für YT, 2020 für Fernsehen & n P3 für Kino, stellst 3 separte ODTs ein und renderst 3 Master. Oder in der Arbeit mit viel VFX vereinfacht es viele Probleme und Workflows, die fehleranfällig sind

Sowas braucht man nicht in jedem Fall, aber sowas ist und macht Sinn.

Ich dachte mir shcon das es anders als ne LUT funktioniert und verlustfrei beim Linearisieren abläuft.

Antwort von WoWu:

Es kommt noch ein weiteres Agument (für 1-Kamera Betrieb) hinzu, nämlich genau das, was wir hier gerade besprechen, dass nämlich IDT vom Kamerahersteller gemacht ist und damit alle Unzulänglichkeiten, die bisherige RAW Entwicklung mit sich brachten, ausgeschaltet werden.

Sofern nicht der Hersteller sein RAW in der Nachbearbeitung unterstützt haben sollte, wurde nämlich damit in den meisten Entwicklungen ziemlicher Mist gebaut ... mit dem Erfolg, dass die Bilder entsprechend aussahen.

IDTs von Herstellern sind soetwas wie die perfekte Bildentwicklung, auf sehr hohem Niveau, aber eben kein RAW.

Das dürfte bei ACES vorbei sein, es sei denn, jemand bastelt sich wieder 'ne IDT zusammen (oder ne LUT) und muckst sich seinen Workflow zurecht, weil er es besser weiß, als die Kamerahersteller ... soll es ja hier und da mal geben, wie man hört.

Antwort von MLJ:

@stip

Dieser Link veranschaulicht sehr gut was den ACES Workflow betrifft:

ACES in 10 Minutes

Cheers

Mickey

Antwort von stip:

Danke für den Link Mickey, aber mein Post ist nicht ernst gemeint.

Dachte das wird beim Durchlesen glasklar :)

Antwort von WoWu:

Nee, wurde es leider nicht ... wenn man mal die Defizite, allein im Umgang mit Sensoren und Übertragungsfunktionen betrachtet (auch in diesem Forum, wenn auch weniger als in andern Foren ) , wäre Dein Posting durchaus plausibel gewesen.

Auf der andern Seite kommt noch hinzu, dass sicher noch Mitleser da sind, die das noch weniger differenzieren können und dann verbreitet sich im. Internet nämlich (auch durch solche Postings) so ein Mist.

Sowas trägt nur zur Verblödung bei ...

Und streng genommen gibst Du ja zu, dass Du Alf nur vera...en wolltest.

Find'st Du das gut ?

Antwort von Alf_300:

@WoWu

Ich habs natürlich immer noch nicht kapiert, ;.-((

und wollte eigentlich wissen mit welche Geräten man den vollern ACES Farbraum darstellen kann.

Antwort von WoWu:

Im Augenblick noch mit gar keinem Monitor, weil der Farbraum (mit Absicht) so groß gewählt worden ist, dass er selbst noch die Entwicklungen der nächste Jahre -(vielleicht Jahrzehnte) abdecken kann.

Das Prinzip besteht darin, die maximal mögliche Kameraqualität zunächst in ein File zu schreiben, aus dem man dann jeden, für seine Anwendung und auch für seine Hardware, erforderlichen Farbraum ableitet.

Lass uns nochmal bei der Milch bleiben, auch wenn ich selbst das Beispiel mistig finde, aber wenn Du aus der Kamera 10 L bekommst, dein Monitor aber nur 5 Liter fassen kann, dann nimmst Du auch nur die 5 L aus dem File (für den Monitor), obwohl die Kamera 10 L hergegeben hat, schüttest aber die restlichen 5l nicht weg (wie bisher) denn wenn Dein Content mit 6 oder 8 l an einen Kunden gehen soll, dann machst Du das auch aus demselben 10l file.

Du bedienst also die 5l Senke, und gleichzeitig die 8l Senke aus dem 10l File, ohne das File zu beschädigen.

Und wenn du im nächsten Jahr einen Monitor bekommst, der 9 l darstellen kann, kannst Du 9 l aus dem File holen, weil Du am Kamerafile nichts änderst.

Du archivierst es mit 10l und nimmst, wann und wo immer Du es brauchst, nur über die entsprechenden Module das heraus, was Du, wo, brauchst.

Das ist das Prinzip.

Also nicht, wie bisher, das File zu beschädigen, indem es in ein 8/10 Bit LOG File gepfercht wird und durch ein De-Bayering in einem schmalen Farbraum festgelegt ist (oft schon in der Kamera, z.B. mit 8/709sRGB) sondern am Bedarf der Hardware und des Zielmediums entlang diese Einengungen vorzunehmen.

Das bedeutet nämlich, dass Du in jeden beliebigen Farbraum wann immer Du willst, die maximal mögliche Qualität liefern kannst, ohne das, wie bisher immer verlustbehaftet hin und her gewandelt werden musste.

Es geht bei ACES also um die maximale Bildqualität.

Solche 16Bit Files werden natürlich nicht kleiner, zumal man es nicht mehr, wie bei echtem RAW nur noch mit einem Wert pro Bildpunkt zu tun hat, sondern wieder mit drei Werten und das in 16 Bit, aber vor 10 Jahren haben wir auch schon über 10 Bit Filegrössen gelabert und mussten feststellen, dass sie nicht proportional wachsen und Speicher nicht nur billiger, sondern auch schneller werden und solche Files eigentlich gar kein wirkliches Problem darstellen.

Daher denke ich, wir sollten HW Anfordeungen einmal gelassen betrachten und uns da nicht jagen lassen.

Dazu kommen nämlich auch noch diverse andere Vorteile, die das Verfahren mit sich bringt.

Antwort von Alf_300:

Danke WoWu

Antwort von motiongroup:

Mal ne frage an den Dr.. wie tun die die Fraktion SoNie Log 3 - 3Cine in Aces unterbringen wenn die teilweise drüberfahren?

Antwort von WoWu:

Ich hab' zwar die Frage nicht verstanden, weil sie etwas kryptisch verfasst ist, aber ich denke du meinst, wie man mit den LOG Üertragungsfunktionen in den ACES Workflow kommt?

Der Hersteller ist in seinen Übertragungsverahren nicht mehr darauf angewiesen und kann sein Signal so übertragen, wie es dem Signal am besten bekommt, hauptsache er reversiert alle Prozesse in seiner IDT, sodass das Resultat in einen linearen Farbraum und einem Umfang von 16 Bit mündet.

Den Anwender interessiert überhaupt nicht mehr, was der Hersteller vor der IDT macht. Das können Übertagungsfunktionen, LUTs oder auch die Kombination aus Funktion und zusätzlichen Stützstellen sein ... oder auch (fast) gar nix, denn das Sensorsignal liegt ja in der Kamera schon linear vor und würde im Idealfall nur noch das De-Bayering ( bei 1 Chip) durchlaufen.

Das, was die Sache bisher so nachteilig macht, sind ja gerade solche Verbigungen und Einengungen auf dem Übertragungsweg, wo das Signal begrenzt wird.

Deshalb ist es ja wichtig, dass IDTs vom Hersteller kommen und nicht das Resultat von irgendwelchen LOG Wandlungen zurück nach ACES sind, denn da sind die Begrenzungen dann nämlich schon eingebacken.

Antwort von motiongroup:

ich meinte wie die das bei Sony handhaben wenn die Werte über resp, außerhalb des Bereiches der Aces Definiton liegen

Antwort von

Antwort von WoWu:

Was willst Du mit werten, die im nicht sichtbaren Bereich liegen ?

Willst Du Thermographie mit ACES bearbeiten?

Antwort von motiongroup:

Das war nicht die Frage, ich wollte wissen wie die das in Aces umsetzten selbst unter dem Aspect das sich Werte außerhalb des sichtbaren Bereichs befinden.. wird das einfach ignoriert..

Antwort von WoWu:

"Die" wären ja mit dem Klammabeutel gepudert, wenn die Wellenlängen, die gar nicht sichtbar sind, in sichtbares Licht an Positionen transferieren, die es dafür gar nicht gibt.

Wenn solche Wellenlängen von der Kamera für irgendwelche Industriezwecke übertragen werden, hat das mit Bildünertragung im Vodeobereich sowieso nichts zu tun.

Davon mal ganz abgesehen, dass "DIE" sowieso nichts machen.

Wenn Sony ACES mit einer IDE unterstützt, dann werden sie den Bereich geflissentlich weglassen.

Oder sie machen da gar nix, der Farbraumbereich ist ja heute schon sinnlos und endet spätestens an den Übertragungseigemschaften der HW Bauteile ist aber toll für das Marketing.

Kommt noch hinzu, dass es ohnehin Schwachsinn ist, sofern die Kamera diesen Bereich tatsächlich unterstützen sollte, denn jeder vernünftige (Film/Video) Anwender filtert solche Bereiche (aus den bekannten Gründen) sowieso am Objektiv raus.

Was nützt also ein Farbraumbereich, den man weder sieht, noch bedient ?

Antwort von motiongroup:

Wenn Sony ACES mit einer IDE unterstützt, dann werden sie den Bereich geflissentlich weglassen.

das war die Frage... und die Antwort

Antwort von Wintermorgen:

WoWu hat geschrieben:

"Die" wären ja mit dem Klammabeutel gepudert, wenn die Wellenlängen, die gar nicht sichtbar sind, in sichtbares Licht an Positionen transferieren, die es dafür gar nicht gibt.

Wenn solche Wellenlängen von der Kamera für irgendwelche Industriezwecke übertragen werden, hat das mit Bildünertragung im Vodeobereich sowieso nichts zu tun.

Entschuldige WoWu, aber das ist so nicht ganz korrekt. Der blaue, sowie der grüne Primary in ARRI Wide Gamut liegen ausserhalb der Spectral Locus im riesigen Chromaticity Diagrammes des AP0 Farbraums (ACES). Der Grund dafür ist auch nicht darauf zu hoffen, Farben verzeichnen zu können die der Mensch ohnehin nicht wahrnehmen kann, sonder – der selbe wie für AP0 – eine Optimierung der mathematischen Präzision bei Berechnungen.

Siehe Diagram: AWG (rot) - Arri Wide Gamut

zum Bild

Übrigens ist ACES genau genommen weder ein Farbraum, noch ein Workflow. ACES ist eine Color Image Pipeline.

Antwort von WoWu:

Danke für die ergänzenden Informationen.

Was die Bezeichnung betrifft, so hat das "Kind" viele Namen.

Ursprünglich wurde es von der AMPAF nur (Interchange Image Framework) bezeichnet, was aber leicht zu falschen Schlüssen führen kann.

Die SMPTE nennt es daher einen "non proprietary standardised workflow".

Aber das wording ist mir in diesem Zusammenhang ziemlich egal.

Antwort von wolfgang:

Die Sorgen um vom menschlichen Auge nicht mehr wahrnehmbare Werte will ich haben. Glaubt hier ernsthaft jemand, dass die heutigen noch halbwegs erschwinglichen Geräte ala FS5/7 etc. s-gamut.cine vollumfänglich aufzeichnen können? Wenn es dafür Belege gibt, dann bitte her damit.

Nicht mal der schweineteure 30.000 Euro HDR Profimonitor von Sony kann den Wunderfarbraum rec2020 zur Gänze darstellen, die im Handel verfügbaren Sichtgeräte schaffen derzeit auch nur DCI P3.

Also ACES als Farbraum heute schon vollumfänglich abzudecken ist wohl noch weit weit weg.

Antwort von WoWu:

Hier werden immer Dinge miteinander vermengt. Natürlich dienen übergroße Farbräume nur zur Berechnung aber es sind doch alles Praktiker hier. Warum führen die sich nicht mal vor Augen, was da eigentlich passiert ...

Eine Kamera hat nämlich gar kein Gamut !

Eine Kamera sieht (quasi) alle Wellenlängen. die man ihre durch das Objektiv anbietet.

Der Hersteleller entscheidet, durch die Breite der Übertragungsfunktion bedingt, wieviel Werte er eigentlich übertragen möchte (kann).

Danach legt er die Primaries fest.

Die Verbindung dieser 3 Werte ergibt das Gamut Dreieck, in dem im De-Bayering alle fehlenden Zwischenwerte gerechnet werden.

Weil einige Werte im nicht sichtbaren Bereich liegen würden, lässt er sie entweder weg und stellt einfach den Farbraum optisch falsch da oder füllt Nullen auf.

Und je weiter er die Primaries nach außen legt, also den Farbraum vergrößert, umso mehr Daten muss er übertragen und Bandbreite vorhalten.

Der Farbraum richtet sich also immer (bisher) nach den zu erwartenden Darstellungsmöglichkeiten und der verfügbaren Bandbreite.

Das ändert sich bei ACES, weil er groß genug gewählt worden ist, zukünftig die Primaries weit zu wählen, ohne dass es solche krummen "Leerräume" im nicht sichtbaren Bereich gibt.

Farbraum hat also nichts mit der Kamera zu tun, sondern nur mit der Wiedergabe.

Während bisher aber immer die Aufnahme (aus ökonomischen Gründen) begrenzt wurde, geschieht das in ACES nicht mehr und erst kurz vor dem Zielmedium wird abgeschnitten.

Der gesamte Qualitätpath ist so hochwertig wie die Kamera und deren IDT.

Deswegen macht es auch so wenig Sinn zu hoffen, dass bisheriges Material durch ACES irgendwie verbessert wird. Es bleibt so gut/schlecht, wie es ist.

Eher wird es durch ein weitere Wandlung noch schlechter.

Zu sagen ... ich kann es nicht darstellen, also mach ich es nicht ist natürlich ziemlich kurz gesprungen.

Aber wenn die Kamera sowieso ACES nicht unterstützt, haben viele kaum eine andere Wahl, als den Content gleich in der Kamera zu beschneiden, sofern sie nicht noch die andern Vorzüge von ACES in ihrem workflow nutzen können.

Antwort von motiongroup:

http://www.lightillusion.com/aces_overview.html

Das ist eigentlich sehr gut erklärt und stellt doch klar , dass Definition Aces in der Summe der Eigenschaften die es in sich Vereint genau das ist was es ist..ein

Workflow in gewissen Spezifizierungen nicht mehr und nicht weniger und wer sich die unteren Bereicher der Auflistung genauer ansieht die passenden Äquivalente dazu findet um selbiges zu erreichen..

Dient dazu wie Wintermorgen schrieb um die durchgehende mathematische genaue Nachvollziebarkeit zu gewährleisten .. done..

Sprich es wird nichts fallen gelassen.. weggezwackt oder der gleichen um es mal nicht mathematisch auszudrücken...

Nun um es für den DAU unter uns , resp mich genauer darzustellen, es hat sich nicht wesentliches geändert wenn ich Quellmaterial verarbeite dessen Bereich weit außerhalb der Berichte liegt die ich abbilden möchte like 709,2020 oder p3

Danke für die Aufklärung nie in die Verlegenheit zu kommen diesen Weg g hin zu müssen..

Antwort von Wintermorgen:

WoWu hat geschrieben:

Danke für die ergänzenden Informationen.

Was die Bezeichnung betrifft, so hat das "Kind" viele Namen.

Ursprünglich wurde es von der AMPAF nur (Interchange Image Framework) bezeichnet, was aber leicht zu falschen Schlüssen führen kann.

Die SMPTE nennt es daher einen "non proprietary standardised workflow".

Aber das wording ist mir in diesem Zusammenhang ziemlich egal.

A non proprietary standardised workflow finde ich treffend, meines Erachtens nach aber unvollständig. Wollen wir uns vielleicht auf einen non proprietary standardised workflow mit einer in sich geschlossenen Image Color Pipeline einigen?

Vielleicht noch ein Anstoss für einige SlashCam Forum Members sich zu vergegenwärtigen, dass ein grösserer Farbraum nicht die Gegebenheit von Farben in der abzubildenden Szene erhöht. In anderen Worten, es kann nicht aufgenommen/verzeichnet werden, was in der Szene nicht existiert.

Es ist sehr unwahrscheinlich, dass der grüne Primary des AP0 Farbraumes in irgendeiner Form in der Natur zu finden ist. Im 3D environment besteht jedoch keine Limitierung von Farbtönen und die Bestimmung dieser ist lediglich von den Möglichkeiten des abbildenden Zielgerätes (Display Device) abhängig. Es ist bereits möglich – durch die Errungenschaft der Laser Projektion in Kombination mit HDR – Farben darzustellen, die bisher noch nie gesehen wurden. Dies wurde bereits anhand von Dolby Vision mit Inside Out (2015) an der letztjährigen IBC erfolgreich demonstriert. Diese extremen Farbtöne wirken auf den Menschen jedoch weitgehend fremd, da diese in der Natur nicht vorkommen und entsprechend nicht unseren Sehgewohnheiten entsprechen.

Antwort von motiongroup:

Vielleicht noch ein Anstoss für einige SlashCam Forum Members sich zu vergegenwärtigen, dass ein grösserer Farbraum nicht die Gegebenheit von Farben in der abzubildenden Szene erhöht. In anderen Worten, es kann nicht aufgenommen/verzeichnet werden, was in der Szene nicht existiert.

Hmmm irgendwie spießt sich diese Aussage...

Es werden doch in Abhängigkeit der verwendeten Technik weit mehr Informationen gesammelt und in eben diesem Falle aufgezeichnet als wahrgenommen oder bedingt durch die Limmitierung der Sichtgeräte wiedergegeben.

Antwort von Wintermorgen:

motiongroup hat geschrieben:

Hmmm irgendwie spießt sich diese Aussage...

Es werden doch in Abhängigkeit der verwendeten Technik weit mehr Informationen gesammelt und in eben diesem Falle aufgezeichnet als wahrgenommen oder bedingt durch die Limmitierung der Sichtgeräte wiedergegeben.

Ich bin mir nicht sicher ob ich verstehe, was du geschrieben hast.

Beziehst du dich vielleicht auf kleinere Farbräume wie z.B.: Rec601, sRGB, Rec709 ... In diesem Falle hättest du natürlich recht, wenn du sagst, dass aktuelle Flaggschiff Produkte diverser Kamerahersteller mehr Informationen aufnehmen können, als in den oben genannten Empfehlungen/Standards letztendlich dargestellt werden.

Ich habe mich jedenfalls auf extrem grosse Farbräume bezogen, wie zum Beispiel Rec2020 oder eben ACES AP0 oder auch ACES AP1, welche bisher eben noch nicht vollkommen dargestellt werden können. Mal sehen, ob wie geplant, im Jahr 2020 der Farbraum Rec2020 vollkommen darstellbar sein wird.